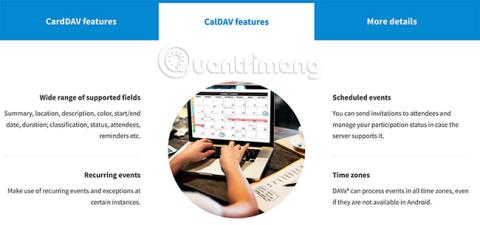

So synchronisieren Sie CalDAV und CardDAV mit Android

Erfahren Sie in diesem Leitfaden, wie Sie CalDAV und CardDAV mit Android synchronisieren können, um Ihre Kalender- und Kontaktdaten effizient zu verwalten.

In letzter Zeit sind wir in Artikeln über Kameras neuer Apple-Geräte häufig auf den Begriff LiDAR-Sensor gestoßen. Dieser Satz wird so häufig verwendet, dass wir vergessen, dass Augmented-Reality-Telefone auf jede erdenkliche Weise funktionieren können, insbesondere mit ToF-Tools, die Samsung-Telefone auf die nächste Stufe heben.

Wo liegt also der Unterschied zwischen LiDAR und ToF? Finden wir es mit Quantrimang heraus.

Was ist ToF?

ToF steht für Time of Flight. Tatsächlich bezieht ToF die Lichtgeschwindigkeit (oder sogar die Schallgeschwindigkeit) ein, um die Entfernung zu bestimmen. Es misst die Zeit, die das Licht benötigt, um das Gerät zu verlassen, das Objekt zu erreichen und wieder zurückzukehren, alles unterteilt in zwei Zeiträume, die die Entfernung vom Gerät zum Objekt oder zur Oberfläche angeben.

Android-Geräte verwenden ToF-Sensoren

Daher ist jedes LiDAR eine Art Time of Flight, aber nicht jedes ToF ist LiDAR. Einfach ausgedrückt bedeutet ToF optische Distanzmessung, die nichts mit LiDAR zu tun hat.

LiDAR steht für Light Detection and Ranging. Diese Technologie verwendet einen Laser oder einen Laserstrahl sowie eine ähnliche Lichtquelle wie oben.

LiDAR-Sensor auf dem iPhone

Ein einzelner LiDAR-Sensor kann verwendet werden, um die Breite eines Raums zu messen, aber mehrere LiDAR-Sensoren können verwendet werden, um eine „Punktwolke“ zu erstellen. Mithilfe dieser Punkte wird ein 3D-Modell eines Objekts oder eine topografische Karte eines gesamten Gebiets erstellt.

Während LiDAR für mobile Geräte möglicherweise neu ist, gibt es die Technologie tatsächlich schon seit einiger Zeit. Wenn LiDAR nicht auf einem Telefon installiert ist, kann es für alles verwendet werden, von der Kartierung von Unterwasserumgebungen bis hin zu archäologischen Stätten.

Unterschied zwischen LiDAR und ToF

Der funktionale Unterschied zwischen LiDAR und anderen Formen von ToF besteht darin, dass LiDAR einen gepulsten Laser verwendet, um eine „Punktwolke“ zu erstellen, die dann zum Erstellen einer Karte oder eines 3D-Bilds verwendet wird. ToF-Anwendungen erstellen „Tiefenkarten“ basierend auf der Lichterkennung, häufig mithilfe einer Standard-RGB-Kamera.

Der Vorteil von ToF gegenüber LiDAR besteht darin, dass ToF weniger spezielle Ausrüstung erfordert und daher mit kleinen und kostengünstigeren Geräten verwendet werden kann. Der Vorteil von LiDAR liegt darin, dass Computer Punktwolken relativ zu Tiefenkarten problemlos lesen können.

Die von Google für Android erstellte Tiefen-API funktioniert am besten auf Geräten, die ToF unterstützen, indem sie eine Tiefenkarte erstellt und „Feature-Punkte“ erkennt. Diese Merkmalspunkte sind häufig Barrieren zwischen unterschiedlichen Lichtintensitäten, die dann zur Definition verschiedener Ebenen in der Umgebung verwendet werden. Dadurch entsteht im Wesentlichen eine Punktwolke mit niedrigerer Auflösung.

Wie ToF und LiDAR mit mobiler AR funktionieren

Tiefenkarten und Punktwolken sind großartig und für einige Benutzer reicht das aus. Für die meisten AR-Anwendungen müssen diese Daten jedoch kontextualisiert werden. Sowohl ToF als auch LiDAR erreichen dies durch die Zusammenarbeit mit anderen Sensoren auf Mobilgeräten. Insbesondere müssen diese Plattformen die Ausrichtung und Bewegung Ihres Telefons verstehen.

Ist LiDAR besser als ToF?

Genauer gesagt ist LiDAR schneller und genauer als ToF. Dies wird jedoch mit neuen Technologieanwendungen immer wichtiger.

Beispielsweise haben die ToF- und Depth-APIs von Google Schwierigkeiten, große Ebenen mit geringer Textur wie weiße Wände zu verstehen. Dies kann es für Anwendungen, die diese Methode verwenden, schwierig machen, digitale Objekte genau auf bestimmten Oberflächen in der physischen Welt zu platzieren. Bei Anwendungen, die LiDAR verwenden, ist dieses Problem weniger wahrscheinlich.

Bei Anwendungen mit strukturell unterschiedlichen oder größeren Umgebungen ist dieses Problem jedoch unwahrscheinlich. Darüber hinaus verwenden die meisten mobilen AR-Anwendungen für Verbraucher AR-Filter auf dem Gesicht oder Körper des Benutzers – eine Anwendung, bei der aufgrund der großen Oberflächen wahrscheinlich keine Probleme auftreten.

Warum verwenden Apple und Google unterschiedliche Tiefensensoren?

Bei der Veröffentlichung von LiDAR-kompatiblen Geräten hat Apple nach eigenen Angaben die Sensoren mit Hardware kombiniert, um „professionellere Arbeitsabläufe zu ermöglichen und professionelle Foto- und Videoanwendungen zu unterstützen“. Das LiDAR-kompatible iPad Pro ist „das weltweit beste Gerät für Augmented Reality“, und das Einführungsprodukt umfasst Apples Mess-Apps.

Google erklärt ausführlich, warum die Depth API und die neue Reihe unterstützender Geräte kein LiDAR verwenden. Durch die Verwendung von LiDAR werden Android-Geräte leichter und erschwinglicher, außerdem bietet die Zugänglichkeit einen großen Vorteil.

Da Android-Telefone von vielen Unternehmen hergestellt werden, wird die Einführung von LiDAR LiDAR-kompatible Modelle gegenüber anderen bevorzugen. Da außerdem nur eine Standardkamera erforderlich ist, ist die Depth API mit mehr Geräten abwärtskompatibel.

Erfahren Sie in diesem Leitfaden, wie Sie CalDAV und CardDAV mit Android synchronisieren können, um Ihre Kalender- und Kontaktdaten effizient zu verwalten.

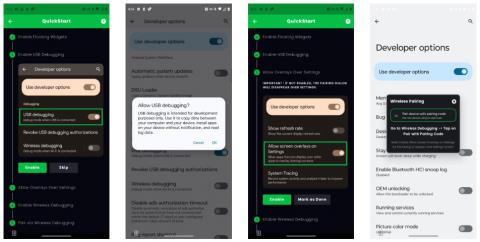

Kurzanleitung zur Deinstallation des Magisk-Moduls ohne Verwendung von Magisk Manager, auch bekannt als Deinstallation des Magisk-Moduls mithilfe von TWRP Recovery oder offline.

Erfahren Sie, wie Sie Kali Linux NetHunter auf Ihrem Android-Telefon installieren, mit detaillierten Schritten und nützlichen Tipps für Penetrationstests.

So deaktivieren Sie die Anzeige des eingegebenen Passworts auf Android und schützen Sie Ihre Daten effektiv.

Entdecken Sie, wie Sie die Tastenbelegung verwenden, um jedes Android-Spiel mit einem Gamepad zu spielen. Diese Anleitung bietet viele Tipps und Tricks für ein besseres Gaming-Erlebnis.

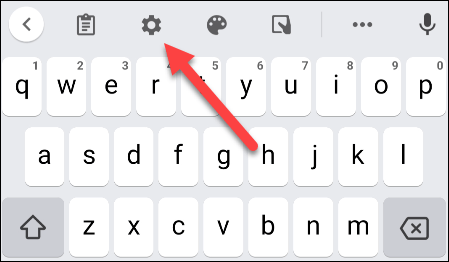

Entdecken Sie, wie Sie mit der Gboard-Tastatur auf Android einfach und schnell Sprache in Text umwandeln können. Nutzen Sie die Spracheingabe für mehr Produktivität.

Erfahren Sie, wie Sie den Vibrationseffekt beim Drücken von Tasten auf Android deaktivieren können, um eine leisere und angenehmere Eingabeerfahrung zu genießen.

Entdecken Sie die besten Panorama-Fotoanwendungen für Android. Diese Apps erleichtern die Panoramafotografie und bieten zahlreiche Funktionen, um beeindruckende Fotos aufzunehmen.

Aktivieren Sie die Leseliste in Google Chrome auf Ihrem Android-Gerät mit einfachen Schritten für einen besseren Überblick über Ihre Leseinhalte.

Entdecken Sie die besten Android-Notiz-Apps mit Startbildschirm-Widgets, um schnell und effektiv Notizen zu machen.