Datenbetreiber machen manchmal Fehler, die zur Schließung des gesamten Rechenzentrums führen können. Die meisten dieser Probleme können jedoch durch Wartungsmaßnahmen, Inspektionsverfahren sowie den gesunden Menschenverstand und die Erfahrung der Anlagenbetreiber vermieden werden.

Ein „ungeplanter Rechenzentrumsausfall“ ist eine höfliche Bezeichnung dafür, dass ein Rechenzentrum Probleme hat, die zu Ausfallzeiten führen. Unabhängig davon, ob die Ursache ein Hardwarefehler, ein Softwarefehler oder ein menschliches Versagen ist, können und sollten die meisten dieser Fehler im Voraus verhindert werden. Aufgrund des hohen Maßes an Risikoredundanz in den heutigen Rechenzentren ist es durchaus möglich, Vorfälle im Voraus zu verhindern.

Interessant ist, dass in einem Rechenzentrum immer noch große und kleine Fehler auftreten können und der Schaden, der entsteht, wenn Rechenzentren den Betrieb einstellen, nicht einmal für kurze Zeit gering ist. Laut einer Studie von Data Center Knowledge können Ausfallzeiten von Rechenzentren Unternehmen etwa 7.900 US-Dollar pro Minute kosten. Tatsächlich gingen 93 % der Unternehmen mit einem Rechenzentrumsausfall von 10 Tagen oder mehr innerhalb eines Jahres bankrott, und 40 % brachen sofort zusammen. Und eine weitere Studie mit 41 ausgewerteten Rechenzentren ergab, dass die durchschnittlichen Kosten ungeplanter Ausfälle mehr als 179.000 US-Dollar an Betriebsunterbrechungen, etwa 118.000 US-Dollar an entgangenen Einnahmen und etwa 42.000 US-Dollar an Produktivität umfassten. Wenn sich Rechenzentrumsmanager einfach mehr auf die Erforschung und Behebung der Hauptursachen häufiger Fehler konzentrieren würden, würden sie die potenziellen Risiken erheblich reduzieren.

Das Problem besteht darin, dass sich viele Rechenzentrumsbetreiber und -betreiber oft stärker auf Wachstum und Umsatz konzentrieren, anstatt das Bestehende zu erhalten und zu stärken. Wenn Sie heute auf die Administratoren in vielen öffentlichen und privaten Rechenzentren achten, werden Sie feststellen, dass es ihnen fast ausschließlich um die Erhöhung der Speicherkapazität, die Erhöhung der Serverdichte und die Erhöhung der Serverdichte geht Kühlsysteme zum Beispiel. All dies ist zwar großartig, dringend notwendig und zeigt ein unglaubliches Wachstum in der Datenspeicherbranche, es zeigt aber auch, warum Rechenzentren ausfallen. Dies kommt immer häufiger vor.

In diesem Artikel werden wir die häufigsten Gründe für die Deaktivierung von Rechenzentren untersuchen und hervorheben, was Administratoren tun können, um diese Probleme zu minimieren oder sogar zu beseitigen. Beheben Sie diese Probleme vollständig und verbessern Sie die Stabilität Ihres Systems.

Gründe, die zum Zusammenbruch des Rechenzentrums führen

Von Menschen verursachter Fehler

Dies sind die einfachsten Ursachen, aber auch eine der am schwersten zu vermeidenden. Einfach ausgedrückt: Jeder kann Fehler machen. Da 22 % der Ausfälle auf menschliches Versagen zurückzuführen sind, lohnt es sich, diese Ursache sorgfältig zu prüfen und, was noch wichtiger ist, sie kann relativ einfach verhindert werden.

Unzulässige Systemautorisierung

Tatsächlich haben nur sehr wenige Administratoren vollständigen und uneingeschränkten Zugriff auf alle Systeme in einem Rechenzentrum. Anstatt diese Berechtigung mehr Personen zu erteilen, muss der Zugriff streng verwaltet werden. Andernfalls ist es durchaus möglich, dass ein schwerwiegender Fehler im System auftritt. Beispielsweise startete ein erfahrener Administrator beim Joyent-Vorfall im Jahr 2014 versehentlich alle virtuellen Maschinen im Ost-Rechenzentrum des Unternehmens mit nur wenigen Klicks neu.

Schlechte Backup-Verfahren

Bei der Planung von Wartungsaufgaben ist der Backup-Prozess ein wichtiger, aber oft vergessener Schritt. Oft werden Prozesse dokumentiert, aber nicht gründlich überprüft, und oft werden die Dinge nach der Wartung nicht vollständig in ihren ursprünglichen Zustand zurückversetzt.

Zu viele Änderungen vornehmen

Wenn ein Administrator während der Wartung versucht, zu viele Änderungen auf einmal vorzunehmen, kann dies zu Problemen führen. Erstens haben Administratoren oft eine gehetzte Mentalität, weil sie eine große Anzahl von Aufgaben in kurzer Zeit erledigen müssen, was oft zu Fehlern führt. Zweitens wird die Fehlerbehebung nach der Änderung zu einer viel schwierigeren Aufgabe, da so viele Änderungen im gleichen Zeitraum stattfinden.

Laxheit im Personalmanagement

Es klingt etwas hart, aber die Mitarbeiter müssen wissen, wie sie die Regeln im Zentrum strikt befolgen und bei Verstößen strenge Disziplinarmaßnahmen ergreifen müssen. Beispielsweise erlaubt kein Rechenzentrum den Mitarbeitern, während der Arbeit zu essen oder zu trinken, oder Notschalter müssen deutlich gekennzeichnet und gesichert sein. Diese Dinge mögen klein erscheinen, können aber zu größeren Zwischenfällen führen. Stellen Sie daher sicher, dass die Regeln immer strikt befolgt werden.

Systemfehler

Die Notstromversorgung ist nicht garantiert, die Ausrüstung ist alt oder falsch konfiguriert.

Der häufigste Grund für den Ausfall eines Rechenzentrums ist ein Stromausfall. Stromausfälle können jederzeit passieren. Daher sind Rechenzentren mit Notstromquellen ausgestattet, falls die Hauptstromversorgung ausfällt. Als Notstromversorgung werden häufig Batterien oder Generatorsysteme eingesetzt. Das Problem besteht darin, dass die Batterie möglicherweise nicht rechtzeitig ausgetauscht wird und der Generator möglicherweise nicht überprüft und gewartet wird, was bei einem Stromausfall zu Problemen führt. All dies bedeutet, dass Ihre Backup-Funktionen möglicherweise nicht dann verfügbar sind, wenn Sie sie am meisten benötigen.

Im Falle eines Stromausfalls nutzen USV-Systeme Batterien als Notstromversorgung, was sie zu einem wesentlichen Bestandteil der Aufrechterhaltung der Betriebszeit von Rechenzentren macht. Allerdings funktioniert der Akku nicht immer gut. Führen Sie die vom Hersteller selbst empfohlenen Wartungsarbeiten durch, um den Zustand der Batterie zu überprüfen. Mindestens vierteljährlich sollten Batterien auf ordnungsgemäßen Einbau, Entladung und Aufladung überprüft werden. Dazu gehören visuelle Inspektionen, Kapazitätsprüfungen und regelmäßige Überwachung durch Software oder den USV-Lieferanten selbst.

Darüber hinaus können hohe Temperaturen die Batterielebensdauer des Systems verkürzen. Der Aufbau eines eigenen USV-Raums kann dazu beitragen, die Abnutzung der Batterielebensdauer zu verringern. Sie sollten außerdem ein häufiges Entladen des Akkus vermeiden und sorgfältig auf lose Verbindungen oder verschlissene Anschlüsse achten. Kurz gesagt, die USV ist ein besonders wichtiges System, das eine angemessene Auslegung, ordnungsgemäße Verwendung und strenge Wartung erfordert.

Störung im Kühlsystem

Mechanische Systeme in einem Rechenzentrum verbrauchen viel Strom, das heißt, sie geben im Betrieb viel Wärme ab. Ein Rechenzentrum kann nach einer Minute Betrieb zum Krematorium werden. Deshalb ist das Kühlsystem so wichtig. Und selbst wenn Sie Temperatursensoren messen und Warnungen an Administratoren senden, müssen Sie sicherstellen, dass Sie genügend Zeit haben, um die Backup-Kühlverfahren des Zentrums umzusetzen, bevor alles schmilzt.

Darüber hinaus sind viele Kühlsysteme nicht wirklich darauf ausgelegt, mit der erhöhten Hitzeentwicklung in einem modernen Rechenzentrum mit hoher Kapazität Schritt zu halten. Auch hier kann die Erfassung von Situationen, in denen Ihr Rechenzentrum zu 100 % ausgelastet ist, bei der Planung besserer Kühlsysteme für die Zukunft hilfreich sein. Darüber hinaus ist die Einrichtung von Warnsystemen für Systemtemperaturschwankungen erforderlich. Sie können einige thermische Modellierungssoftware und einige DCIM-Systeme verwenden. Darüber hinaus sind chemische Kältemittel eine bessere Wahl als Systeme auf Wasserbasis.

Der automatische Konvertierungsprozess funktioniert nicht ordnungsgemäß

Die meisten Dienstanbieter sowie Organisationen und Unternehmen verfügen über Backup-Rechenzentren, die als Produktions-Rechenzentren genutzt werden. Im Falle eines Stromausfalls im primären Rechenzentrum wird das Backup-Rechenzentrum automatisch gestartet und der gesamte Datenverkehr wird an diese Backup-Einrichtung weitergeleitet. Bei ordnungsgemäßer Durchführung sollte der Prozess bis zum Endbenutzer nahtlos verlaufen. Leider funktionieren automatische Failovers oft nicht wie erwartet. Die übliche Ursache für dieses Problem ist das Fehlen regelmäßiger Tests. Selbst kleine Änderungen in der Produktionsinfrastruktur können große Auswirkungen auf das automatisierte Failover haben. Daher müssen bei Änderungen an der Infrastruktur die automatisierten Failover-Verfahren getestet werden, um sicherzustellen, dass nichts vom Prozess abgewichen ist.

Veraltete Hardware

Die gesamte Hardware jedes Systems hat eine bestimmte Lebensdauer. Und je länger Sie eine Hardware verwenden, desto wahrscheinlicher ist es, dass Probleme auftreten. Jeder weiß das, aber es kommt häufig vor, dass eine wichtige Anwendung abstürzt, nur weil sie auf 10 Jahre alter Hardware läuft. Diese Probleme entstehen häufig aufgrund fehlender umfassender Ersatz- und Upgradepläne für neue Hardware- oder Softwareplattformen oder aufgrund fehlenden Budgets. Wenn es um Geld geht, können Sie nichts tun. Aber wenn man einfach versucht, den Vorteil so lange wie möglich auszunutzen, kann es jederzeit zu einem Problem kommen, und wenn es passiert, kann der durch das Problem verursachte Schaden viel größer sein.

Das Feuerlöschsystem hat ein Problem mit Wasserlecks

Die meisten modernen Rechenzentren verwenden wasserlose Brandschutzsysteme, damit die Geräte bei absichtlicher oder versehentlicher Aktivierung nicht beschädigt werden. Doch viele ältere Einrichtungen nutzen in ihren Rechenzentren noch immer traditionelle Brandschutzsysteme. Viele Wasserlecks haben zu größeren Ausfällen geführt.

Die Notabschaltung wurde versehentlich aktiviert

Das hohe Maß an physischer Sicherheit in den meisten Rechenzentren schreckt Diebe nicht nur ab. Sie dienen auch dazu, Mitarbeiter zu meiden, die nicht verstehen, wie ein Rechenzentrum funktioniert. Beispielsweise betritt ein Anwendungsadministrator das Rechenzentrum und löst versehentlich eine Notabschaltung (EPO) aus. EPO ist ein großer roter Knopf, der dafür verantwortlich ist, die Stromversorgung des gesamten Systems zu unterbrechen. Und für diejenigen, die es nicht verstehen oder keine Fachkenntnisse haben, ist eine solche Verwirrung natürlich durchaus möglich.

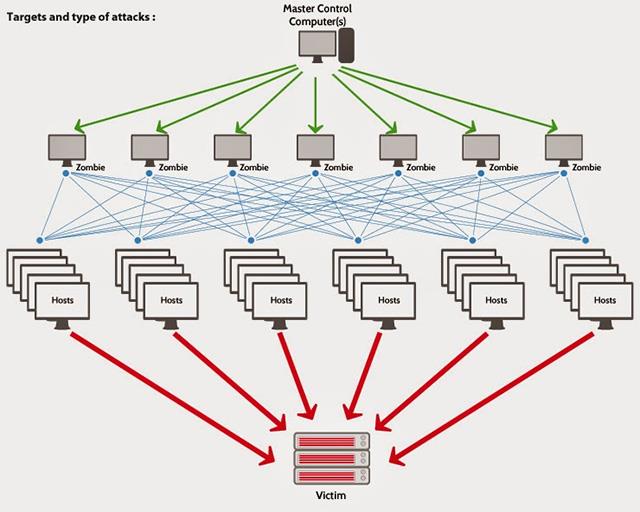

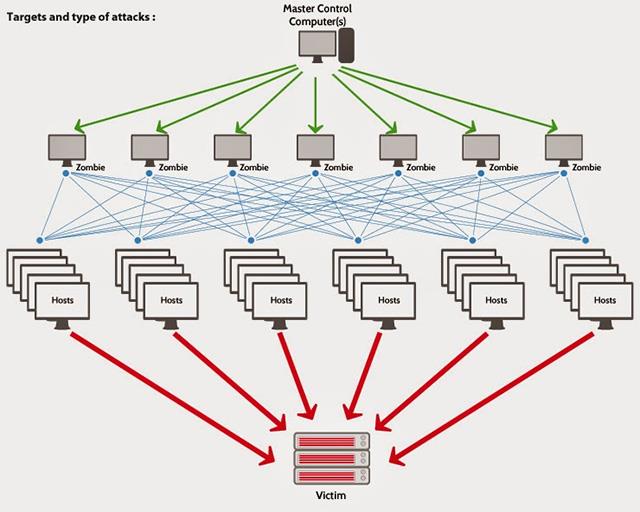

Unter Cyberangriff, ddos

Im Laufe der Jahre haben sich Cyberangriffe zu einer der Hauptursachen für Ausfälle von Rechenzentren entwickelt, von nur 2 % im Jahr 2010 auf 22 % im Jahr 2016. Betreiber von Rechenzentren müssen Maßnahmen ergreifen, um Systeme einzurichten, mit denen die Risiken von Angriffen frühzeitig erkannt und gemindert werden können.

Rechenzentren sind schwer gegen einen groß angelegten DDoS-Angriff zu verteidigen. Die meisten ISPs bieten einen gewissen Schutz auf den Schichten 3 und 4 des Netzwerks, aber Ihre Dienste benötigen zusätzlichen Schutz auf Schicht 7, der gezielt über HTTP-GET oder ähnliche Angriffe angegriffen werden kann. Abwehrdienste wie Firewalls, IPS/IDS und DDoS können kombiniert werden, um den Datenverkehr umzuleiten.

Naturkatastrophe

Die jüngste Zunahme von Stürmen und Überschwemmungen kann zu erheblichen Störungen in Rechenzentren führen. Im Jahr 2010 ereigneten sich in den Vereinigten Staaten mehr als 250 Naturkatastrophen. Laut Statistik erlitt der US-Bundesstaat New Jersey im Jahr 2012 durch Betriebsunterbrechungen durch den Supersturm Sandy Verluste in Höhe von 63,9 Milliarden US-Dollar.

Schritte zur Schadensbegrenzung durch „Einsturz“-Vorfälle im Rechenzentrum

Wenn Ausfallzeiten für routinemäßige Wartungsarbeiten sorgfältig geplant werden und Kunden im Voraus über Ausfallzeiten im Zentrum gewarnt werden, insbesondere in Zeiten mit geringem Verkehrsaufkommen, sind die Kunden mitfühlender und Schäden werden deutlich reduziert. Der größte Schaden entsteht, wenn er unerwartet und vor allem über einen längeren Zeitraum auftritt und zusätzliche Probleme auftreten. Halten Sie das Ressourcensystem des gesamten Unternehmens stabil, damit die Mitarbeiter ihre Arbeit effektiv erledigen können, und reduzieren Sie so die Belastung der IT-Abteilungen.

Speziell:

- Sichern Sie Ihre Daten: Falls es zu einem Ausfall Ihres Rechenzentrums kommt, sollten Ihre Daten (und noch wichtiger die Daten Ihrer Kunden) bereit sein, wenn Sie beginnen. Beginnen Sie mit der Fehlerbehebung und führen Sie den Vorgang erneut aus. Die Durchführung regelmäßiger Backups begrenzt das Risiko eines echten Zusammenbruchs. Wenn Ihr Unternehmen es sich leisten kann, können einige Produkte wie die VPLEX-Produktlinie von EMC oder die Backup- und Replikationssoftware von VEEAM dazu beitragen, Ausfallzeiten zu minimieren, indem sie automatisch zu einem Standort wechseln. Backup.

- Sorgen Sie für eine regelmäßige Überwachung des Serversystems: Die Überwachung ist eine Dienstleistung, die Sie regelmäßig durchführen können und die in der Regel nicht allzu viel kostet. Ein Überwachungsdienst eines Drittanbieters benachrichtigt Sie über mögliche Serverausfälle, sodass Sie sich sofort um das Problem kümmern können.

- Minimieren Sie menschliches Versagen: Seien Sie vorsichtig, wenn Sie an Serversystemen oder elektrischen Leitungen arbeiten oder herumlaufen, um sie nicht versehentlich zu beschädigen, oder berühren Sie einfach keine mysteriösen Schalter ohne Ihr Fachwissen. Thema. Halten Sie Flüssigkeiten von mechanischen Systemen fern. Rufen Sie jederzeit einen Datenschutzspezialisten an, wenn ein Server aktualisiert oder gewartet werden muss, und halten Sie sich an die Regeln des Zentrums.

Jedes Rechenzentrum, von kleinen Zentren bis hin zu Einrichtungen und Dienstanbietern im Unternehmensmaßstab, muss sich zu 100 % darum bemühen, den Benutzern zuverlässige Dienste bereitzustellen. Indem Sie sich die Zeit nehmen, für die Zukunft zu planen und dabei die Grundsätze der Wartung und der menschlichen Faktoren einhalten, kann Ihr Rechenzentrum einige der häufigsten Fehlerursachen vermeiden. Ausfallprobleme.

Mehr sehen